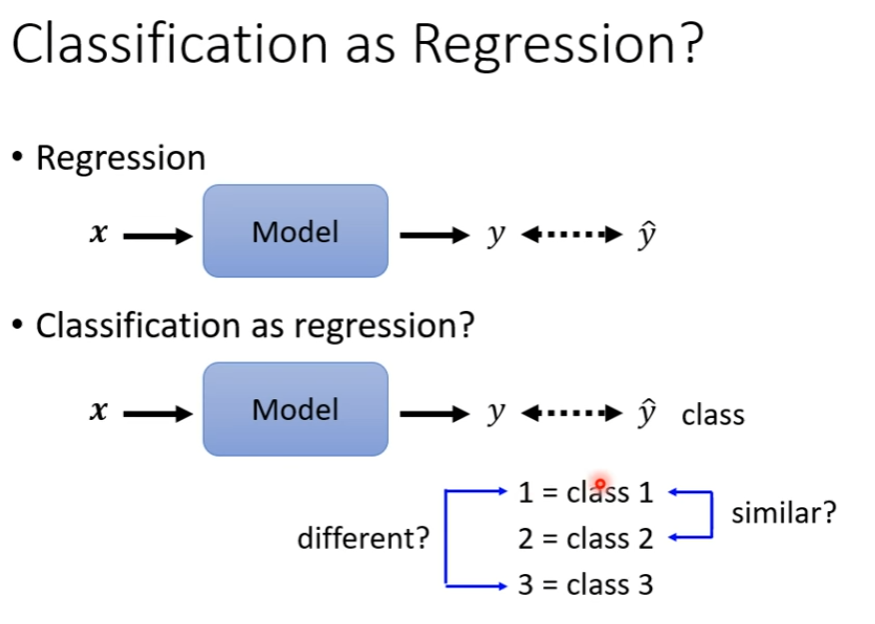

Classification

这样会假定不同的类之间的关系远近

这样会假定不同的类之间的关系远近

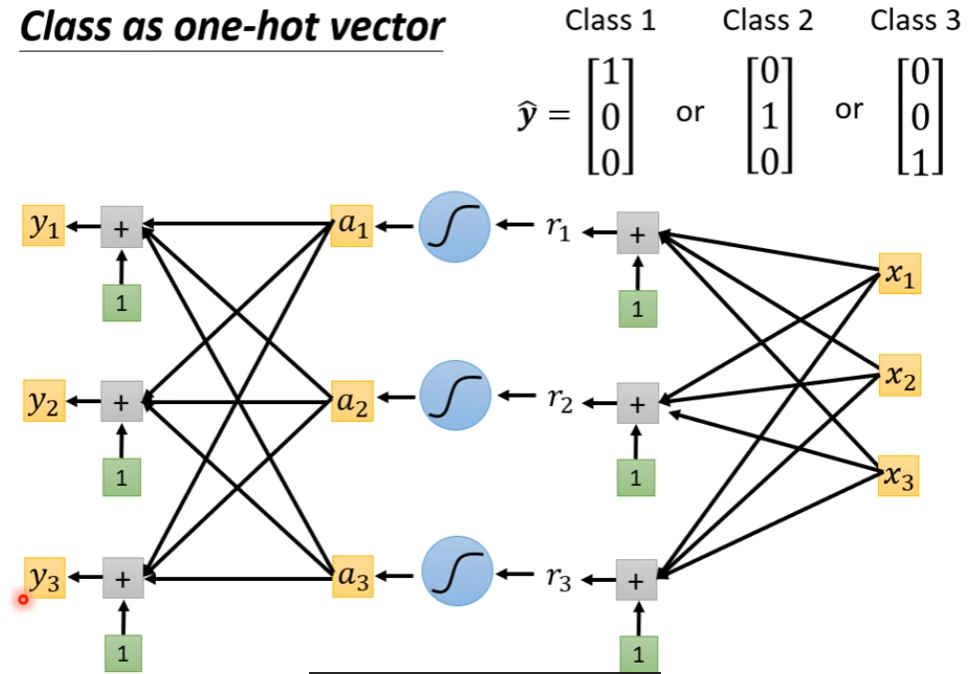

Class as One-Hot Vector

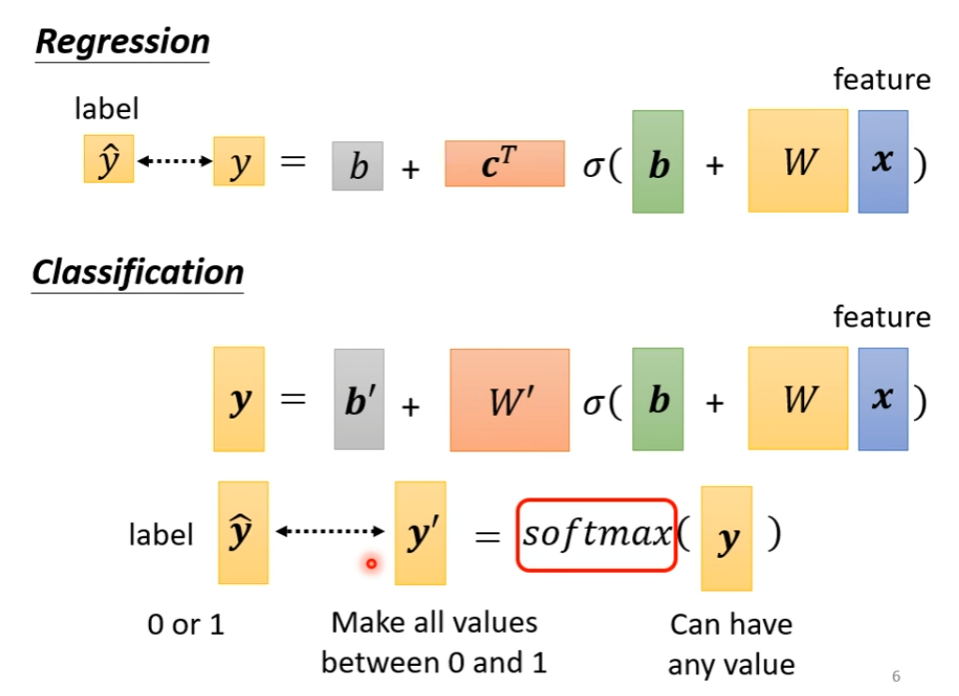

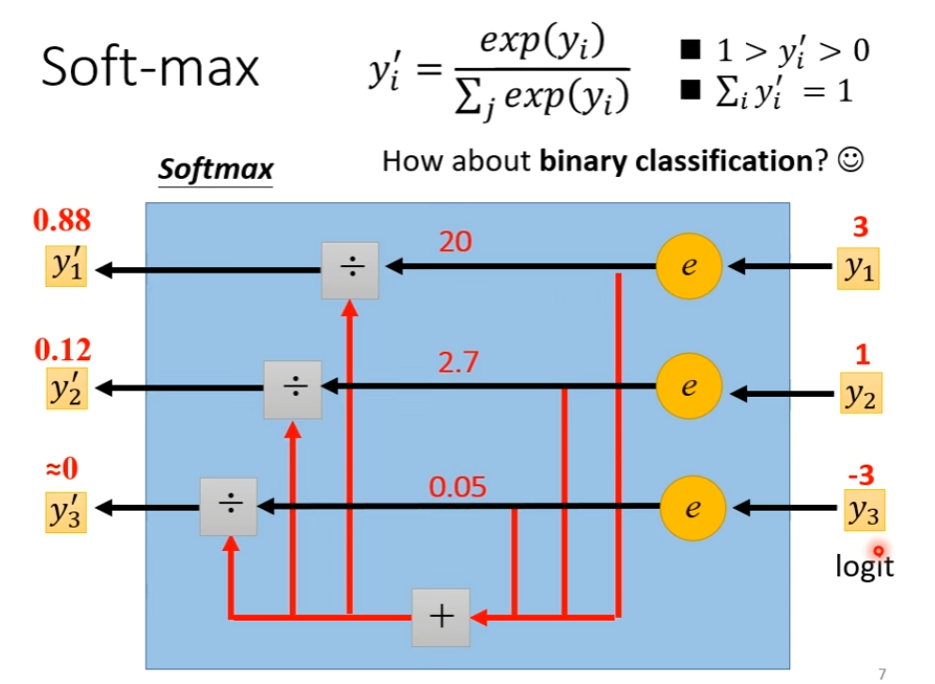

Softmax 用于归一化

Softmax 用于归一化

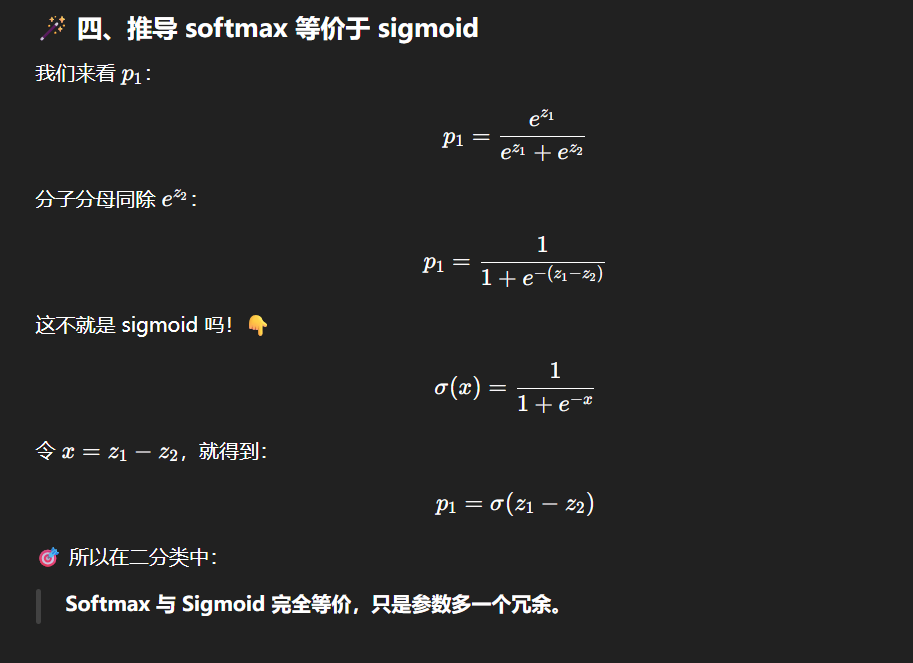

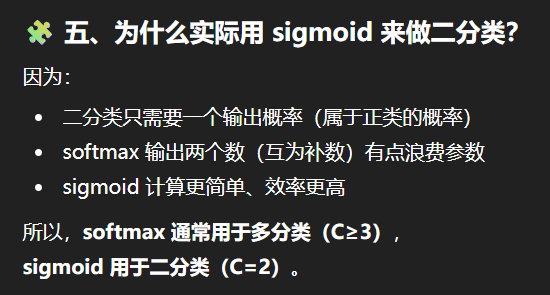

当两个 class 时,我们常用 sigmoid ,与 softmax 等价

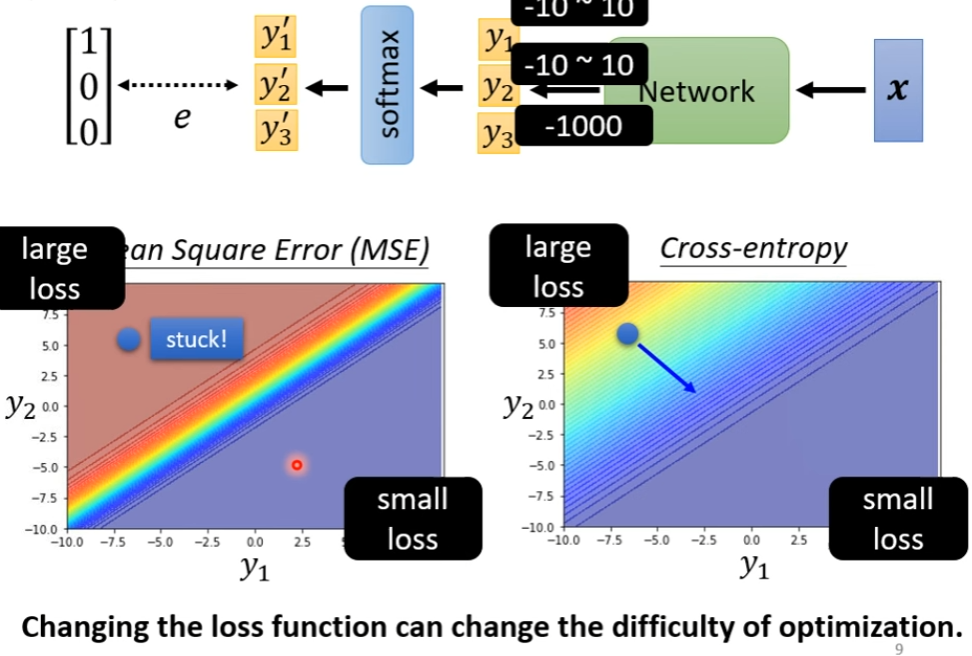

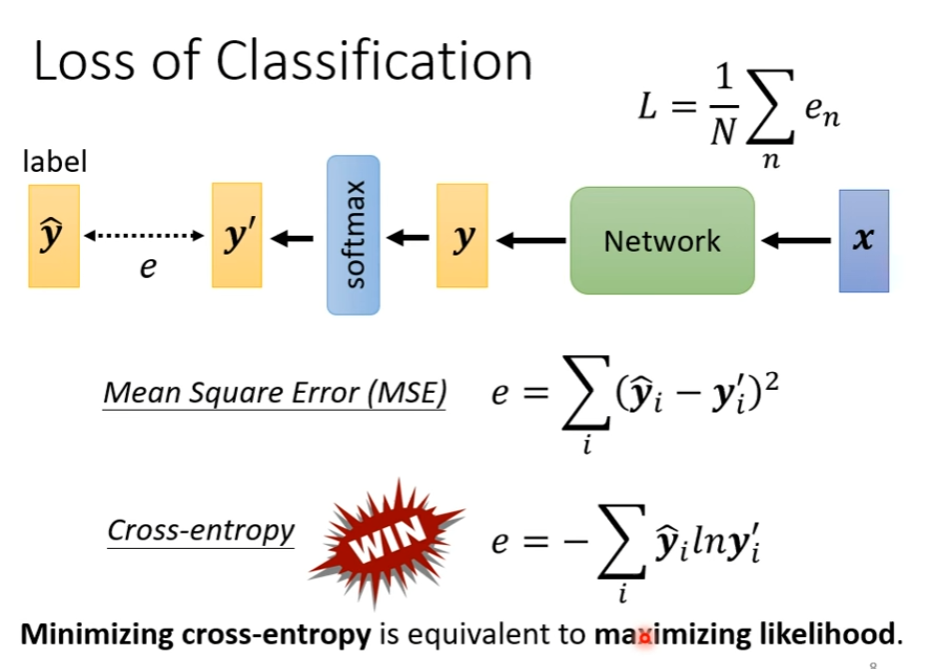

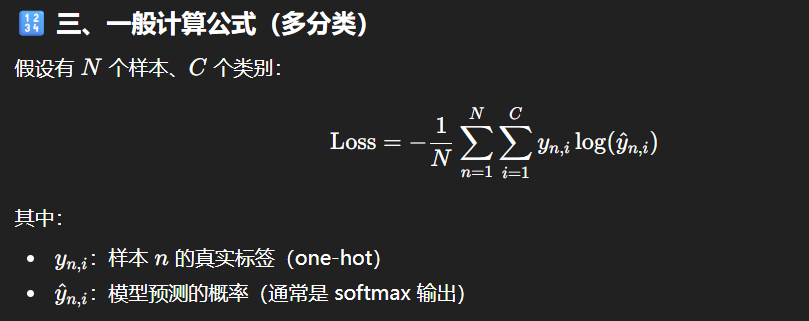

Loss

Cross-entropy 如此常用,以至于 pytorch 里,softmax 被放在了 cross-entropy 里

Cross-entropy 如此常用,以至于 pytorch 里,softmax 被放在了 cross-entropy 里

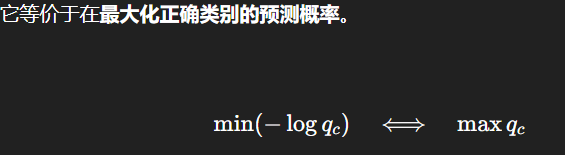

惩罚模型对分类预测的不自信,因为正确结果越接近 1,Loss 越小,如果结果不正确或者不确信,Loss 就比较大。

惩罚模型对分类预测的不自信,因为正确结果越接近 1,Loss 越小,如果结果不正确或者不确信,Loss 就比较大。

Example